Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

Tags

- logistic regression

- AI

- tensorflow

- Softmax classification

- pwnable.kr

- programmers

- 텐서플로

- Algorithm

- 기능개발

- 인공지능

- leg

- Linear_regression

- Python

Archives

- Today

- Total

나혼자 공부장

Softmax Classification 본문

softmax classification이란 binary classification이 두 가지 경우밖에 비교하지 못한다는 한계를 극복하고,

여러가지 클래스로 나뉘어진 경우를 비교할 수 있다.

- 위 사진으로 예를 들면, 중간고사 점수 2.0, 기말고사 점수 1.0, 출석점수 0.1 인 경우에서 학점을 추측해봤을 때,

A - 0.7 (70%)

B - 0.2 (20%)

C - 0.1 (10%)

로 A일 가능성이 가장 높다고 예측할 수 있다.

cost 함수

cost 함수의 원리를 자세히 이해하기 위해

logistic sigmoid에서 x가 0일 때 무한대, 1일 때 0에 수렴한다고 가정해보자.

- [0,1]이 정답이라고 하고, 예측값을 [1,0]으로 잡는다면

[0,1] * [0,무한] (예측값을 sigmoid에 대입해본 값) = [0,무한] -> 0+무한 = 무한 (cost값) (즉, 정답과 거리가 멈)

- 그 반대로 예측값을 [0,1]로 잡는다면

[0,1] * [0,0] = [0,0] -> 0+0 = 0(cost값) (정답임)

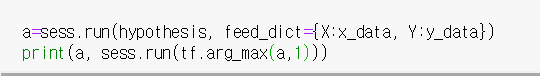

다음과 같이 학습을 시켜준 후

hypothesis를 run 시켜보면 위 softmax 학습으로 인해 정확한 결과를 출력하고 있다는걸 알 수 있다.

(셋 중 가장 큰 숫자의 인덱스를 리턴하는 것임)

Fancy ver.

'AI' 카테고리의 다른 글

| ML tip : Learning rate, Overfitting, Regularization (0) | 2019.04.16 |

|---|---|

| Logistic Regression (0) | 2019.03.31 |

| Linear Regression (0) | 2019.03.31 |

Comments